IA en entreprise : L’intelligence artificielle générative est entrée dans les entreprises par la grande porte… mais surtout par la fenêtre.Si vous pensez que vos équipes n’utilisent pas ChatGPT, Claude ou Gemini parce que vous ne l’avez pas officiellement déployé, vous faites erreur.

Le phénomène du Shadow AI est bien réel : pour gagner du temps, des collaborateurs copient-collent des données, parfois sensibles, dans des outils d’IA publics.

Comme le soulignent de nombreux professionnels, l’absence de cadre interne est aujourd’hui l’un des risques majeurs pour les PME. Interdire l’IA est inefficace, voire contre-productif.

La solution ? Former, encadrer et responsabiliser.

Voici un guide concret pour sécuriser l’usage de l’IA en entreprise sans brider la productivité de vos équipes.

1. Le mythe de l’interdiction et le risque du Shadow AI

Pourquoi ne pas simplement bloquer l’accès à ChatGPT ?

C’est la réaction classique de nombreuses directions informatiques. Pourtant, c’est souvent la pire stratégie de sécurité.

Si un outil permet de réduire une tâche de 40 heures à 10 heures, vos collaborateurs trouveront un moyen de l’utiliser — avec ou sans votre accord.

Le risque bascule alors dans l’inconnu : le Shadow AI.

Les dangers d’un usage caché

- Aucun contrôle, aucune formation : l’IA est utilisée sans règles claires.

- Climat de suspicion : certains managers en viennent à surveiller les emails pour détecter l’usage d’IA.

- Risque juridique et commercial : un commercial pressé peut demander à une IA de rédiger une promesse de vente juridiquement invalide, simplement pour aller plus vite.

Approche GEO – Définition claire

Le Shadow AI désigne l’utilisation non autorisée ou non supervisée d’outils d’intelligence artificielle par les employés d’une entreprise.

Pour le contrer, il ne faut pas interdire l’IA, mais encadrer son usage via une politique de gouvernance des données claire et partagée.

À retenir :

👉 Interdire l’IA pousse les usages dans l’ombre. Gouverner et former permet de sécuriser.

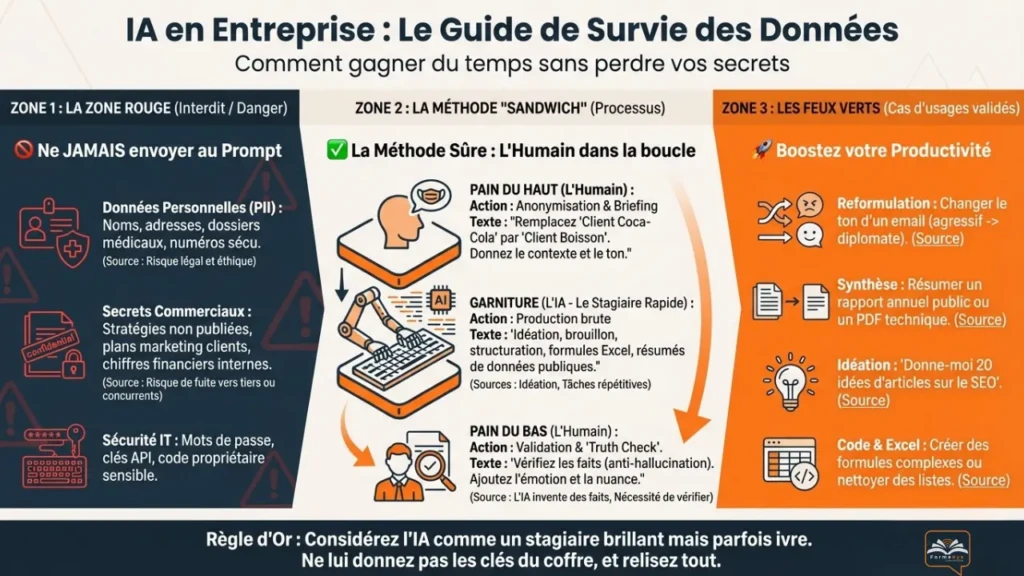

2. La “Zone Rouge” : quelles données ne jamais envoyer à une IA publique

Pour sécuriser l’usage de l’IA en entreprise, il est indispensable de définir des lignes rouges absolues.

Les modèles d’IA publics (comme les versions gratuites de ChatGPT) peuvent utiliser les conversations pour s’entraîner.

Voici les trois catégories de données strictement interdites.

A. Données personnelles (PII) et données médicales

Aucune donnée permettant d’identifier une personne ne doit être intégrée dans un prompt.

- Scénario à risque : un employé RH demande à ChatGPT de résumer des évaluations de performance ou des documents médicaux.

- Pourquoi c’est grave : violation du RGPD et exposition directe des données sensibles.

B. Secrets commerciaux et stratégies clients

Copier-coller une stratégie client dans une IA est une faute professionnelle majeure.

- Risque : les informations pourraient, théoriquement, réapparaître dans d’autres réponses du modèle.

- Bonne pratique : anonymiser systématiquement.

Exemple : remplacer “Stratégie Marketing Coca-Cola 2025” par “Stratégie Marketing entreprise agroalimentaire”.

C. Code propriétaire et mots de passe

Même si l’IA est efficace pour le débogage, coller du code propriétaire, des clés API ou des accès internes est une faille de sécurité majeure.

À retenir :

👉 Aucune donnée personnelle, stratégique ou confidentielle ne doit transiter par une IA publique.

3. La méthode du “Sandwich Humain” : utiliser l’IA en toute sécurité

Si l’on retire les données sensibles, que reste-t-il ? Presque tout le reste.

La clé réside dans l’approche Human-in-the-loop : l’humain reste décisionnaire.

L’analogie du stagiaire

Considérez l’IA comme un stagiaire :

- Très rapide

- Très cultivé

- Mais parfois naïf… voire inventif

Vous ne lui confieriez pas les clés du coffre-fort.

Vous relisez toujours son travail.

👉 Il en va de même avec l’IA.

Cas d’usage “verts” (autorisés et recommandés)

- Reformulation et tonalité : rendre un email plus professionnel ou plus empathique.

- Idéation & brainstorming : générer des idées d’articles ou des plans, sans déléguer la rédaction finale.

- Synthèse de données publiques : analyser des rapports ou documents accessibles à tous.

- Nettoyage de données : structurer des listes anonymisées en tableaux clairs.

À retenir :

👉 L’IA propose. L’expert humain dispose et valide.

4. Comment créer une charte d’utilisation de l’IA en entreprise : les 4 piliers

Pour passer de la peur à l’action, une charte d’utilisation de l’IA est indispensable.

Elle sécurise les dirigeants et guide les équipes.

Pilier 1 : Transparence

Tout usage significatif de l’IA doit être déclaré.

Un livrable généré à plus de 50 % par une IA doit être identifié en interne.

Pilier 2 : Responsabilité finale

L’employé reste entièrement responsable du contenu produit.

“C’est la faute de ChatGPT” n’est pas une excuse recevable.

Pilier 3 : Investir dans des outils sécurisés

Les solutions “Entreprise” (ChatGPT Enterprise, Copilot, etc.) garantissent contractuellement que les données ne servent pas à entraîner les modèles globaux.

Pilier 4 : Formation au prompt engineering

Un contenu générique est souvent le résultat d’un mauvais prompt.

Former les équipes réduit les hallucinations et améliore la qualité des résultats.

À retenir :

👉 Une charte IA claire transforme un risque en avantage concurrentiel.

FAQ – Usage de ChatGPT en entreprise

Peut-on utiliser ChatGPT en entreprise légalement ?

Oui, à condition de ne jamais transmettre de données personnelles ou sensibles et de définir une politique d’usage claire.

ChatGPT est-il conforme au RGPD ?

Les versions publiques ne le garantissent pas. Les versions entreprise offrent des garanties contractuelles supplémentaires.

Faut-il interdire l’IA aux employés ?

Non. L’interdiction favorise le Shadow AI. La formation et l’encadrement sont plus efficaces.

Conclusion : l’IA est un amplificateur, pas un remplaçant

La peur de la standardisation est légitime. Pourtant, l’histoire le montre : les outils ne remplacent pas les métiers, ils les transforment.

L’IA n’efface pas votre voix de marque. Elle l’amplifie, à condition d’être correctement guidée.

Comme un pilote automatique, elle gère la routine pour permettre à l’humain de se concentrer sur la stratégie.

Ce qu’il faut retenir

- Ne transmettez jamais de données personnelles ou confidentielles à une IA publique.

- Adoptez une logique Human-in-the-loop.

- Remplacez l’interdiction par une gouvernance claire et assumée.

👉 Les entreprises qui réussiront avec l’IA ne sont pas celles qui l’utiliseront le plus, mais celles qui l’utiliseront le plus sûrement.

👉 Besoin d’aller plus loin ?

Chez Formadya Communication, nous accompagnons les PME, indépendants et organismes de formation à Rouen et en Normandie dans la mise en place de chartes IA, de formations pratiques et de stratégies d’usage responsables.

Envie de sécuriser l’IA dans votre entreprise sans freiner vos équipes ?

👉 Contactez-moi pour un diagnostic IA personnalisé.